Robots.txt 和 SEO:用途完整指南

Robots.txt 和 SEO:用途完整指南

什麼是Robots.txt?

Robots.txt 是一個文件,告訴搜尋引擎蜘蛛不要抓取網站的某些頁面或部分。大多數主要搜尋引擎(包括 Google、Bing 和 Yahoo)都會識別並尊重 Robots.txt 請求。

為什麼 Robots.txt 很重要?

大多數網站不需要robots.txt檔案。

這是因為 Google 通常可以找到您網站上的所有重要頁面並為其編制索引。

他們會自動不索引不重要的頁面或其他頁面的重複版本。

也就是說,您想要使用 robots.txt 檔案有 3 個主要原因。

封鎖非公開頁面:有時您的網站上有一些您不希望編入索引的頁面。例如,您可能有頁面的暫存版本。或登入頁面。這些頁面需要存在。但你不希望隨機的人登陸它們。在這種情況下,您可以使用 robots.txt 來阻止搜尋引擎抓取工具和機器人存取這些頁面。

最大化抓取預算:如果您很難將所有頁面編入索引,則可能存在抓取預算問題。透過使用 robots.txt 封鎖不重要的網頁,Googlebot 可以將更多的抓取預算花在真正重要的網頁上。

防止資源索引:使用元指令可以像 Robots.txt 一樣防止頁面被索引。但是,元指令不適用於多媒體資源,例如 PDF 和影像。這就是 robots.txt 發揮作用的地方。

底線是什麼?Robots.txt 告訴搜尋引擎蜘蛛不要抓取您網站上的特定頁面。

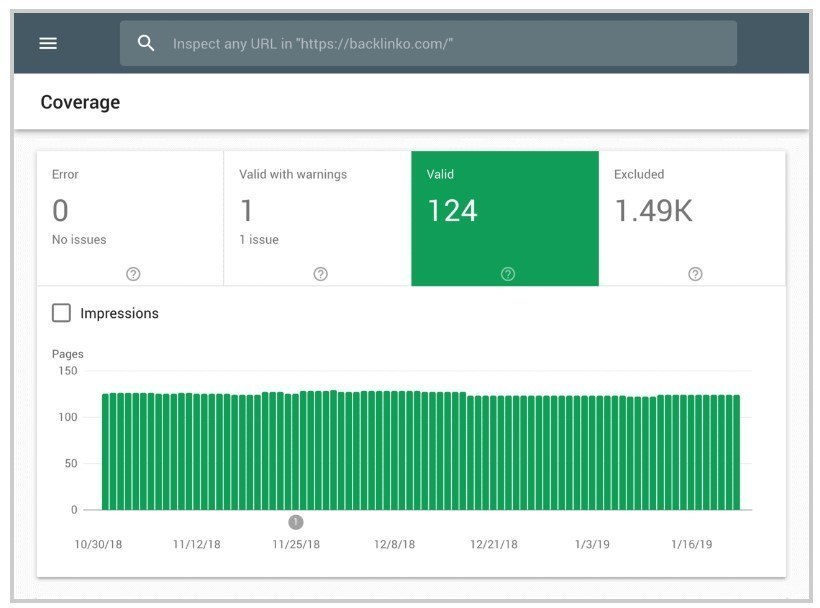

您可以在Google Search Console中檢查您已將多少頁面編入索引。

如果該數字與您想要索引的頁面數匹配,則無需費心使用 Robots.txt 檔案。

但如果該數字高於您的預期(並且您注意到不應編入索引的索引網址),那麼就需要為您的網站建立 robots.txt 檔案了。

最佳實踐

建立 Robots.txt 文件

第一步是實際建立 robots.txt 檔案。

作為一個文字文件,您實際上可以使用 Windows 記事本來建立一個。

無論您最終如何製作 robots.txt 文件,其格式都是完全相同的:

用戶代理:X

禁止:Y

用戶代理是與您交談的特定機器人。

「禁止」之後的所有內容都是您要封鎖的頁面或部分。

這是一個例子:

使用者代理:googlebot

禁止:/images

該規則將告訴 Googlebot 不要為您網站的圖像資料夾建立索引。

您也可以使用星號 (*) 與造訪您網站的所有機器人對話。

這是一個例子:

用戶代理:*

禁止:/images

“*”告訴所有蜘蛛不要抓取您的圖像資料夾。

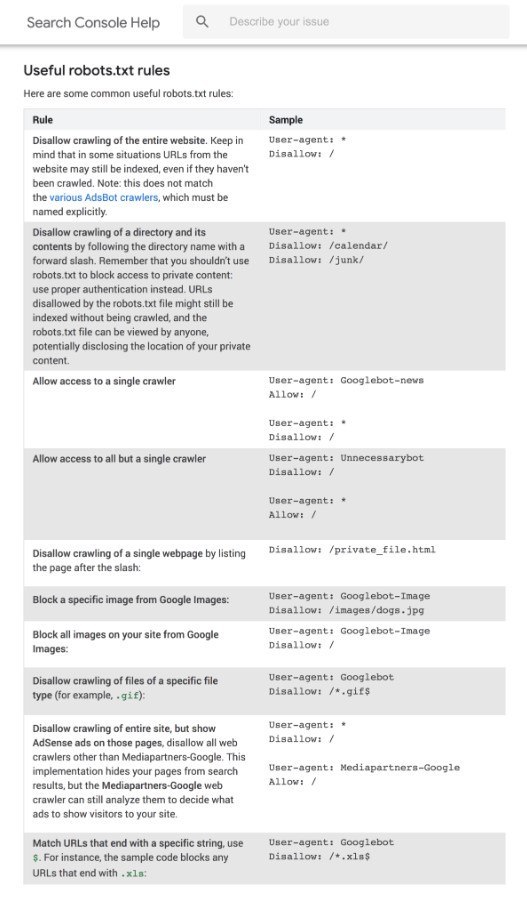

這只是使用 robots.txt 檔案的多種方法之一。Google 提供的這份實用指南提供了有關可用於阻止或允許機器人抓取網站不同頁面的不同規則的更多資訊。

讓您的 Robots.txt 檔案易於找到

獲得 robots.txt 檔案後,就可以將其投入使用了。

從技術上講,您可以將 robots.txt 檔案放置在網站的任何主目錄中。

但為了增加 robots.txt 檔案被發現的幾率,我建議將其放置在:

https://example.com/robots.txt

(請注意,您的 robots.txt 檔案區分大小寫。因此請確保在檔案名稱中使用小寫“r”)

檢查錯誤和錯誤

正確設定 robots.txt 檔案非常重要。一個錯誤,您的整個網站就可能被取消索引。

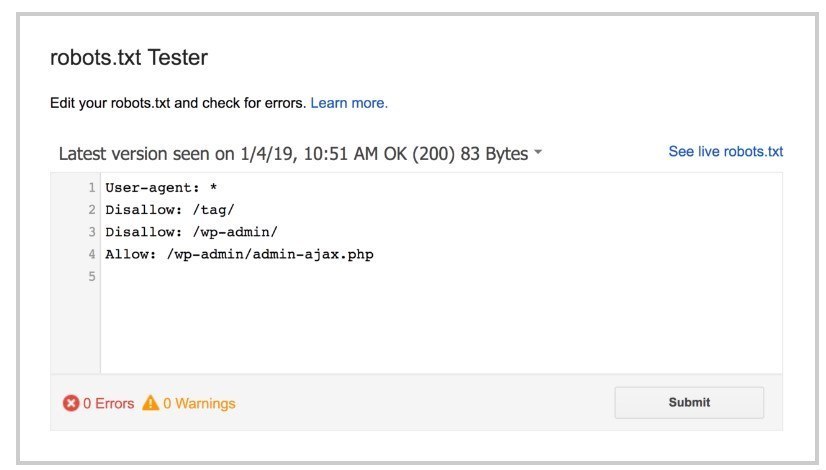

幸運的是,您不需要希望代碼設定正確。谷歌有一個漂亮的機器人測試工具,您可以使用:

它會向您顯示您的 robots.txt 檔案…以及它發現的任何錯誤和警告:

正如您所看到的,我們阻止蜘蛛爬行我們的 WP 管理頁面。

我們也使用 robots.txt 來阻止抓取 WordPress 自動產生的標籤頁面(以限制重複內容)。

Robots.txt 與元指令

當您可以使用「 noindex 」元標記在頁面層級阻止頁面時,為什麼還要使用robots.txt ?

正如我之前提到的,noindex 標籤在影片和 PDF 等多媒體資源上實現起來很棘手。

此外,如果您想要封鎖數千個頁面,有時使用 robots.txt 封鎖網站的整個部分會比手動在每個頁面上新增 noindex 標記更容易。

還有一些邊緣情況,您不想在 Google 登陸帶有 noindex 標記的頁面上浪費任何抓取預算。

那是說:

除了這三種邊緣情況之外,我建議使用元指令而不是 robots.txt。它們更容易實施。而且發生災難的可能性也較小(例如封鎖整個網站)。

了解更多

了解 robots.txt 檔案:有關如何使用和解釋 robots.txt 的有用指南。

什麼是 Robots.txt 檔案?(SEO 概述 + 關鍵見解):關於 robots.txt 不同用例的簡潔影片。