生成式 AI 與誹謗:新型聲譽威脅的形態

人工智慧 AI 聊天機器人正在改變誹謗的傳播方式。如今,維護信譽意味著要密切注意 AI 對你的評價。

隨著生成式 AI 人工智慧越來越深入地融入搜尋和內容體驗,它也正在成為虛假資訊和聲譽損害的新來源。

AI 聊天機器人產生的虛假或誤導性陳述已經引發法律糾紛,並引發了關於責任、準確性和線上聲譽管理的新問題。

目錄

- 當人工智慧成為誹謗的根源時

- 人工智慧在聲譽管理中的作用日益增強

- 如何應對人工智慧誹謗?

- 應對人工智慧領域聲譽損害的其他方法

- 舊法律,新風險

當人工智慧成為誹謗的根源時

AI成為誹謗和網路聲譽損害的新來源,這並不令人意外。

身為搜尋引擎優化和聲譽的專家證人,我已經接到一些訴訟案件的當事人的諮詢,這些案件中人工智慧系統發表了誹謗性言論。

這是一個未知的領域——雖然解決方案正在湧現,但其中許多方面仍然是全新的領域。

人工智慧產生誹謗的真實案例

一位客戶聯繫了我,因為 Meta 的 Llama AI 產生了關於一位知名人士的虛假、誤導性和誹謗性言論。

早期調查顯示,此人曾參與並贏得誹謗訴訟,這些訴訟曾被新聞媒體報道。

一些批評者也在網路上批評了這個人,Reddit 上的討論充斥著不準確和煽動性的言論。

然而,當被問及此人或其聲譽時,人工智慧重複了那些已被駁斥的說法,並添加了新的警告,也提出了欺詐和不可信的斷言。

在另一個案例中,一位客戶發現,在 ChatGPT 中,幾乎所有關於他們的提示都會顯示相同的虛假聲明,而該客戶正是誹謗性部落格文章的目標。

關鍵問題是:即使法院下令刪除原始帖子,這些誹謗性言論會在人工智慧回覆中持續多久?

谷歌趨勢顯示,與透過人工智慧聊天機器人傳播的誹謗以及人工智慧相關的線上聲譽管理相關的搜尋量出現了顯著激增:

捏造的故事和現實世界的危害

在其他一些訴訟文件中披露的案例中,生成式人工智慧顯然憑空捏造了關於人們的完全虛假且有害的內容。

2023 年,喬治華盛頓大學公共利益法沙皮羅教授喬納森特利被錯誤地指控性騷擾——這一指控從未提出,也從未發生過,而他當時所在的學院他從未教過課。

ChatGPT 引用了一篇從未發表過的《華盛頓郵報》文章作為其消息來源。

9 月,前 FBI 特工詹姆斯·基恩 (James Keene) 對谷歌提起訴訟,因為谷歌的人工智慧錯誤地聲稱他因多項罪名被判處終身監禁,並稱他是三名女性的兇手。

訴訟還稱,這些虛假陳述可能被數千萬搜索者看到。

生成式人工智慧可以編造關於人的故事——這就是「生成式人工智慧」中的「生成式」部分。

收到提示後,人工智慧聊天機器人會分析輸入內容,並根據從大量文字中學習到的模式產生回應。

因此,人工智慧的回答有時包含關於個人的虛假和誹謗性內容也就不足為奇了。

改進措施和尚存挑戰

過去兩年,人工智慧聊天機器人處理個人傳記資訊的能力有所提升。

最知名的聊天機器人公司似乎都專注於改進其係統,以便更好地處理涉及人物和專有名詞的查詢。

因此,關於個人的假訊息(或幻覺)的產生似乎已顯著減少。

人工智慧聊天服務提供者也開始在回覆中加入更多免責聲明,涉及人們的個人資訊和聲譽。

這些聲明通常包括以下內容:

- 資訊有限。

- 對某人身分的不確定性。

- 缺乏獨立核實。

目前尚不清楚此類免責聲明究竟能在多大程度上防止虛假或有害的斷言,但至少比完全不發出警告要好。

在其中一個案例中,一位據稱因 Meta 的人工智慧而誹謗的客戶,其律師直接與該公司聯繫。

據報道,Meta 迅速採取行動處理此事,甚至可能已經道歉,這在企業民事責任案件中幾乎是聞所未聞的。

現階段,人工智慧帶來的最大聲譽風險並非來自徹頭徹尾的捏造。

更緊迫的威脅來自人工智慧系統:

- 曲解原始資料以得出不準確的結論。

- 重複他人的誹謗性言論。

- 以誤導性的方式誇大和歪曲事實。

法律責任與第 230 條

由於有關人工智慧產生的誹謗的法律仍在快速發展中,因此很少有法律先例來界定公司對其人工智慧聊天機器人產生的誹謗性言論應承擔何種責任。

有人認為,《通訊規範法》第 230 條可以保護人工智慧公司免於承擔此類責任。

其理由是,如果線上平台在很大程度上可以免於因其託管的第三方內容而受到誹謗索賠,那麼人工智慧系統也應該受到類似的保護,因為它們的產出來自第三方。

然而,「衍生」遠非引用或複製——它意味著相當程度的原創性。

如果立法者已經認為人工智慧的輸出受第 230 條保護,他們可能就不會提議暫停執行州或地方對人工智慧模型、系統和決策過程的限制長達 10 年。

該暫停令最初包含在川普總統的預算協調法案 HR1(又稱「一項美好的法案」)中,但最終在 2025 年 7 月 4 日該法案簽署時被刪除。

人工智慧在聲譽管理中的作用日益增強

人工智慧產生的答案(例如Google的AI 概覽)日益普及,使得有關個人背景和聲譽的資訊更加顯而易見,也更具影響力。

隨著這些系統變得越來越準確可靠,不難想像,公眾會更傾向於相信人工智慧對某人的評價——即使這些資訊是虛假的、誤導性的或誹謗性的。

人工智慧在背景調查中也扮演著越來越重要的角色。

例如,Checkr 開發了一種客製化的人工智慧,用於搜尋和顯示有關個人的潛在負面或誹謗性資訊——這些發現可能會限制一個人在使用該服務的公司中的就業機會。

雖然Google、OpenAI、微軟和Meta等主要人工智慧供應商已經實施了防護措施來減少誹謗的傳播,但像Checkr這樣的服務不太可能包含警告或免責聲明。

因此,此類系統產生的任何誹謗性內容都可能不會被受影響的人注意到。

目前,當網路上已經存在誹謗性網頁或文件時,人工智慧最有可能產生誹謗性言論。

刪除這些原始資料通常可以修正或消除人工智慧輸出中的錯誤訊息。

但隨著人工智慧系統越來越「記住」先前的回答——或者快取資訊以節省處理時間——刪除原始來源可能不再足以消除人工智慧產生的答案中的誹謗性或錯誤說法。

如何應對人工智慧 AI 誹謗?

解決人工智慧平台上出現的誹謗問題的一個關鍵方法是直接要求平台更正或刪除關於你的虛假和有害言論。

如上所述,一些平台(例如 Meta)已經採取行動,刪除疑似誹謗的內容。

(諷刺的是,現在讓 Meta 從其 Llama AI 中刪除有害內容可能比從 Facebook 中刪除更容易。)

如果請求來自律師,這些公司可能會更積極回應,不過他們似乎也願意對個人提交的報告採取行動。

以下是聯絡各大人工智慧供應商,請求其刪除誹謗性內容的方法:

Llama

使用Llama 開發者回饋表或發送電子郵件至 LlamaUseReport@meta.com舉報或要求刪除虛假或誹謗性內容。

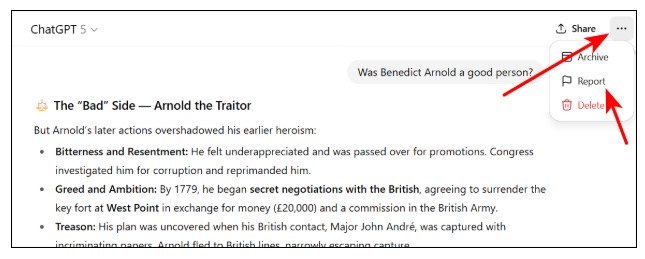

ChatGPT

在 ChatGPT 中,您可以直接在聊天介面內舉報問題內容。

在電腦上,點選右上角的三個點,然後從下拉式選單中 選擇「報告」 。

在行動裝置或其他裝置上,該選項可能出現在不同的選單下。

AI Overviews and Gemini

向Google舉報內容有兩種方式。

您可以出於法律原因舉報內容。 (點擊「查看更多選項」選擇 Gemini,或在 Gemini 桌面介面中,使用回覆下方的三個點。)

但是,除非有法院命令,否則谷歌通常不會以這種方式刪除內容,因為它無法確定材料是否具有誹謗性。

或者,您也可以直接發送回饋。

對於 AI 概覽,點擊結果右側的三個點,然後選擇「回饋」。

在 Gemini 中,點擊「踩」圖示並填寫回饋表單。

雖然這種方法可能需要時間,但谷歌之前也曾透過輕微的抑制來降低有害或誤導性資訊的可見度——類似於其對自動完成功能的處理方式。

提交回饋意見時,請說明:

- 你不是公眾人物。

- 人工智慧概述部分不公平地突出了負面內容。

- 即使來源頁面仍然在線,您也會希望谷歌限制其顯示。

Bing AI 概述與 Microsoft Copilot

與Google一樣,您可以發送回饋或報告問題。

在 Bing 搜尋結果中,點擊 AI 概覽下方的「踩」圖示即可開始回饋流程。

在 Copilot 聊天機器人介面中,點擊 AI 產生的回覆下方的「拇指向下」圖示。

提交回饋時,請清楚、有禮貌地描述有關您的內容有哪些不準確或有害之處。

對於合法移除請求,請使用微軟的「報告問題」表單。

但是,如果沒有法院命令宣布該內容非法或誹謗,這條路不太可能成功。

Perplexity AI

如需從 Perplexity AI 中刪除有關您自己的信息,請發送電子郵件至support@perplexity.ai並提供相關詳細資訊。

Grok AI

您可以點擊回覆下方的三個點來回報 Grok 中的問題。法律問題也可以透過 xAI 報告。

根據xAI的隱私權政策:

- “請注意,我們無法保證模型輸出結果的真實性。如果輸出結果包含與您相關的不實個人信息,您可以提交更正請求,我們將盡力更正這些信息——但由於我們模型的技術複雜性,我們可能無法做到完全更正。”

若要提交更正請求,請造訪https://xai-privacy.relyance.ai/。

應對人工智慧領域聲譽損害的其他方法

如果聯絡人工智慧提供者後問題仍未完全解決,您還可以採取其他措施來限製或阻止虛假或有害資訊的傳播。

從源頭移除負面內容

除了人工智慧幻覺產生的誹謗性或破壞性言論的案例越來越少之外,大多數有害內容都是從現有的線上資源中收集或總結出來的。

努力移除或修改這些來源,以降低人工智慧在回覆中顯示它們的可能性。

說服是第一步,如果可能的話。例如:

- 在新聞文章中加入聲明,承認其中存在事實錯誤。

- 請注意,法院已裁定該內容不實或構成誹謗。

這些可能會觸發人工智慧防護機制,防止材料重複出現。

免責聲明或撤回聲明也可以阻止人工智慧系統複製負面訊息。

用正面和中性資訊淹沒人工智慧

有證據表明,人工智慧會受到可用一致資訊量的影響。

發布足夠多的關於某人的準確、正面或中立的資料,可以改變人工智慧對可靠資訊的判斷。

如果大多數資訊來源反映的是相同的傳記細節,那麼人工智慧模型可能會更傾向於採納這些細節,而不是孤立的負面說法。

但是,新內容必須出現在信譽良好的網站上,這些網站的權威性必須與發布負面內容的網站相當或更高——當有害內容來自主要新聞媒體、政府網站或其他可信的網域時,這是一個挑戰。

消除搜尋引擎結果中的負面訊息

根據我的測試,查詢的複雜程度決定了人工智慧可以參考的結果數量,從前 10 個結果到幾十個甚至更多。

這意味著:如果你能將負面結果進一步推到搜尋排名的下方——超出人工智慧通常會搜尋的範圍——那麼這些項目就不太可能出現在人工智慧產生的回覆中。

這是一種經典的線上聲譽管理方法:利用標準的 SEO 技術和線上資源網路來取代搜尋結果中的負面內容。

然而,人工智慧又增加了一層新的難度。

ORM 專業人員現在需要確定每個 AI 模型會掃描結果追溯多遠,以回答有關人員或主題的問題。

只有到那時,他們才能知道必須將有害結果推向何種程度才能「清理」人工智慧的反應。

過去,將負面內容從搜尋結果的前一兩頁移除,可以減輕其影響約 99%。

如今,這往往還不夠。

AI 系統可能會從更深層的搜尋索引中提取資訊——這意味著 ORM 專家必須抑制更廣泛頁面和相關查詢中的有害內容。

由於人工智慧在產生答案時可以進行多次語義相關的搜索,因此測試各種關鍵字組合併清除所有相關搜尋結果中的否定項至關重要。

透過創造同名角色來混淆視聽。

使用與名譽受損者「巧合地」同名的角色,長期以來一直是一種偶爾使用、迫不得已的策略。

對於那些不願在網路上發布更多關於自己的媒體內容的人來說,這一點尤其重要——即使這樣做可以幫助抵消不公平、誤導性或誹謗性的內容。

諷刺的是,這種不情願往往會加劇問題:網路存在感薄弱會使一個人的聲譽更容易受到損害。

當多個人共用一個名字時,人工智慧聊天機器人似乎會更加謹慎,如果無法確定訊息指的是誰,它們通常會避免發表具體的聲明。

這種趨勢可以被利用。

透過創建多個同名且擁有看似合法的數位足跡的完善的線上身份,可以使人工智慧難以確定所指究竟是哪個人。

這種不確定性可能會阻止他們散佈或重複誹謗性材料。

這種方法並非沒有缺點。

人們越來越多地同時使用人工智慧和傳統搜尋工具來查找個人訊息,因此添加新的身份可能會造成混淆或意外洩露。

不過,在某些情況下,使用可信賴的替代身分「混淆視聽」可以有效地減少或淡化人工智慧產生的回覆中的誹謗性關聯。

舊法律,新風險

為減輕人工智慧相關誹謗受害者所遭受的傷害,可能需要採用結合上述方法的混合方法。

有些誹謗行為一直很難——有時甚至不可能——透過訴訟來解決。

訴訟費用昂貴,而且可能需要數月甚至數年才能獲得結果。

在某些情況下,提起訴訟會受到職業或法律限制,使情況更加複雜。

例如,醫生如果想就誹謗性言論起訴病人,可能會因披露身分資訊而違反 HIPAA 法案;律師也可能面臨各自律師協會道德規範下的類似挑戰。

還有一種風險是,長期隱藏在搜尋結果中的誹謗——或者因訴訟時效而無法提起訴訟的誹謗——可能會透過人工智慧聊天機器人的回應突然重新出現。

這最終可能會導致有趣的判例法,認為人工智慧產生的回應構成誹謗內容的“新發布”,從而有可能重新設定這些索賠的限制。

另一個可能的解決方案(儘管實現起來比較遙遠)是倡導制定新的法律,以保護個人免受人工智慧系統傳播的負面或虛假資訊的侵害。

其他地區,例如歐洲,已經制定了隱私法,包括“被遺忘權”,賦予個人對其個人資訊更大的控制權。

類似的保護措施在美國會很有價值,但鑑於第 230 條的持久效力,這種保護措施仍然不太可能實現,該條款繼續保護大型科技公司免於承擔網路內容的責任。

人工智慧引發的聲譽損害仍然是一個快速發展的領域——無論從法律、技術或戰略層面來看都是如此。

預計未來會有更多發展,法院、立法者和技術專家將繼續努力應對這一新興領域。